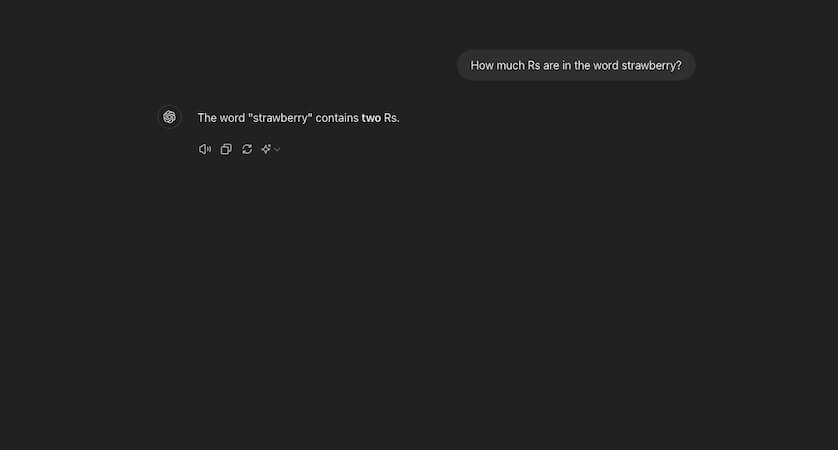

KI kann den Buchstaben „R“ in dem Wort „Strawberry“ nicht zählen. Doch woran liegt es, dass die meisten Systeme an so einer so vergleichbar einfachen Aufgabe scheitern?

Künstliche Intelligenz und vor allem große Sprachmodelle (LLMs) können viele Aufgaben auf beeindruckende Art und Weise erledigen. Mit Tools wie ChatGPT oder Google Gemini stellt das Verfassen von Aufsätzen und das Lösen komplexer Gleichungen oftmals kein Problem mehr dar.

Doch in manchen Fällen scheitern KI-Systeme an einfachen Dingen, wie der korrekten Schreibweise eines einzelnen Wortes. Es kommt etwa häufig vor, dass Künstliche Intelligenz auf die Frage, wie oft der Buchstabe „R“ in dem Wort „Strawberry“ vorkommt, die falsche Antwort liefert.

Diese Fehler verdeutlichen, dass KI-Systeme zwar extrem leistungsfähig, aber eben nicht menschlich sind. Denn Algorithmen „denken“ nicht wie wir und haben damit kein Verständnis für grundlegende sprachliche Konzepte wie Buchstaben oder Silben. Doch wieso sind komplexe mathematische Formeln oftmals kein Problem, während das englische Wort „Strawberry“ fast alle Modelle aus dem Konzept bringt?

KI kann „R“ in „Strawberry“ nicht zählen – wegen Aufspaltung in Tokens

Das liegt vorwiegend daran, dass LLMs auf Transformator-Architekturen basieren. Diese zerlegen die Text in sogenannte „Tokens“. Diese Tokens können je nach Modell ganze Wörter, Silben oder einzelne Buchstaben darstellen. Dabei wandelt ein Tool den eingegebenen Text in eine numerische Darstellung um, die dann das dahinterstehende KI-System verarbeitet.

So weiß die KI vielleicht, dass „straw“ und „berry“ zusammen „strawberry“ ergeben. Doch sie versteht nicht, aus welchen Buchstaben das Wort genau besteht. Dieser Mechanismus macht es der KI schwer, genaue Buchstaben oder deren Anzahl in einem Wort zu erkennen.

Eine der größten Herausforderungen bei dieser Problematik ist die Definition dessen, was ein „Wort“ für ein Sprachmodell bedeutet. Auch wenn es möglich wäre, eine perfekte Token-Vokabular-Liste zu erstellen, würden LLMs wahrscheinlich immer noch Schwierigkeiten haben, komplexere sprachliche Strukturen zu verarbeiten.

Verschiedene Sprachen folgen den verschiedensten grammatikalischen Regeln

Besonders schwierig wird es, wenn ein LLM mehrere Sprachen lernen muss. Denn einige Sprachen wie Chinesisch oder Japanisch haben keine Leerzeichen, um Wörter zu trennen. Das macht die Tokenisierung umso komplexer. Eine mögliche Lösung wäre, dass Sprachmodelle direkt mit einzelnen Zeichen arbeiten, anstatt eine Tokenisierung vorzunehmen.

Doch momentan ist das für Transformator-Modelle zu rechenintensiv. Während sich die Technologien weiterentwickeln, bleibt abzuwarten, wie gut zukünftige KIs mit diesen Herausforderungen umgehen können. Vielleicht ermöglicht die schier unendliche Rechenleistung eines Quantencomputers Künstlicher Intelligenz jedoch eines Tages, die Grammatik wie ein Mensch aufzunehmen und zu verstehen.

Auch interessant: