ChatGPT-Mutterkonzern OpenAI hat kürzlich ein neues KI-Modell vorgestellt. Bei der Einführung von OpenAI o1 wolle der Konzern jedoch „vorsichtig“ vorgehen, da das Modell für die Herstellung von Biowaffen missbraucht werden könnte.

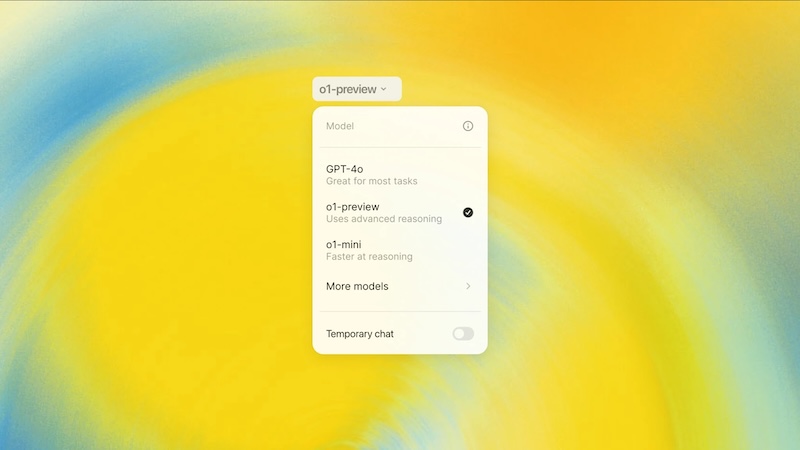

Mit der Einführung von ChatGPT hat OpenAI die Welt der Künstlichen Intelligenz revolutioniert. Nun hat der Konzern mit OpenAI o1 ein neues KI-Modell vorgestellt.

OpenAI o1 benötigt laut Unternehmensangaben zwar „mehr Zeit zum Denken“. Allerdings sei die KI in der Lage, komplexe Aufgaben zu durchdenken und schwierigere Probleme in den Bereichen Wissenschaft, Programmierung und Mathematik zu lösen.

Doch genau dadurch könnte das neue KI-Modell gefährlich werden. Deshalb hat der Konzern OpenAI o1 mit der höchsten Risikostufe versehen, die er jemals für eines seiner Modelle vergeben hat.

Könnte OpenAI o1 für Herstellung von Biowaffen missbraucht werden?

OpenAI hat sein neues KI-Modell als „mittleres Risiko“ im Zusammenhang mit der Herstellung chemischer, biologischer, radiologischer und nuklearer Waffen eingestuft. Gegenüber der Financial Times hat das Unternehmen erklärt, dass OpenAI o1 die Fähigkeit von Experten, Biowaffen zu entwickeln, „erheblich verbessert“ hat.

KI-Modelle, die in der Lage sind, schrittweise Schlussfolgerungen zu ziehen, könnten in den falschen Händen ein erhöhtes Risiko für Missbrauch mit sich bringen. Mira Murati, CTO von OpenAI, erklärte gegenüber der Financial Times, dass das Unternehmen aufgrund dieser neuen Fähigkeiten bei der Einführung in die Öffentlichkeit besonders „vorsichtig“ vorgehen wolle. Für Abonnenten von ChatGPT und Programmierer werde die KI allerdings allgemein zugänglich sein.

Red Teamer und Experten aus verschiedenen wissenschaftlichen Bereichen haben das Modell getestet, um es an seine Grenzen zu bringen. Laut Murati habe die KI bei den allgemeinen Sicherheitskriterien jedoch weitaus besser abgeschnitten als die vorherigen.

Experten fordern Gesetze zur Einschränkung von KI-Modellen

Die neuen Möglichkeiten, die das KI-Modell o1 mit sich bringt, „verstärkt die Bedeutung und Dringlichkeit“ von Gesetzen zur Regulierung von Künstlicher Intelligenz, so Yoshua Bengio, Professor für Informatik an der Universität von Montreal, gegenüber der Financial Times.

Ein solches Gesetz wird derzeit in Kalifornien diskutiert. Die Hersteller von KI-Modellen müssten demnach Maßnahmen ergreifen, um beispielsweise das Risiko für die Entwicklung von Biowaffen zu minimieren.

Bengio, der einer der weltweit führenden KI-Wissenschaftler ist, sieht die Gefahr in der stetigen Weiterentwicklung von KI-Modellen. „Die Risiken werden weiter zunehmen, wenn die richtigen Leitplanken fehlen“, so der Forscher. „Die Verbesserung der Fähigkeit von KI, zu denken und diese Fähigkeit zur Täuschung zu nutzen, ist besonders gefährlich.“

Auch interessant: