Im Internet kursieren immer mehr Deepfakes. Sie stellen ein Gefahr dar, weil sie täuschend echt wirken. Eine neue Studie liefert nun eine Methode, um Deepfakes von echten Bildern zu unterschieden zu können.

Deepfakes sind täuschend echt wirkende, jedoch künstlich erstellte oder veränderte Fotos-, Video- oder Sprachaufzeichnungen. So lautet die Definition der deutschen Bundesregierung.

Das Problem: Cyberkriminelle nutzen Deepfakes für Phishing, Desinformation und die Manipulation der öffentlichen Meinung. Denn durch fortschrittliche Künstliche Intelligenz ist es mittlerweile sehr schwer, Deepfakes zu entlarven.

Studie erklärt, wie sich Deepfakes von echten Aufnahmen unterscheiden

Eine Studie der Royal Astronomical Society zeigt, dass es bei vielen Deepfakes ein Detail gibt, durch das sie sich von echten Fotos unterscheiden lasen: die Lichtreflexion im Auge. So können KI-generierte Fälschungen durch die Analyse des menschlichen Auges erkannt werden.

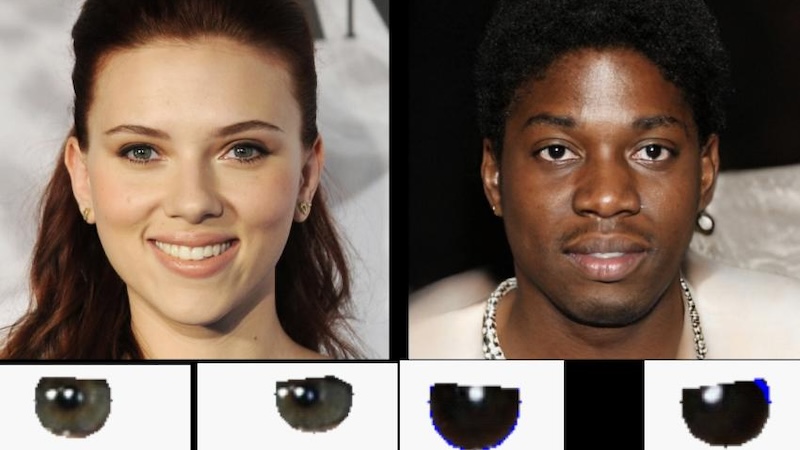

In einer offiziellen Pressemitteilung zeigen die Astronom:innen dafür als Beispiel ein Bild: Auf der linken Seite ist eine echte Abbildung der Schauspielerin Scarlett Johansson zu sehen. Auf der rechten Seite befindet sich ein Foto einer Person, das eine Künstliche Intelligenz erstellt hat.

Unter der Abbildung befinden sich Nahaufnahmen der Augäpfel beider Menschen. Dort ist zu sehen, dass die Reflexionen bei der echten Person konsistent und bei der künstlichen Person physikalisch falsch sind.

Das heißt: Wenn die Spiegelungen in den Augäpfeln übereinstimmen, ist das Bild wahrscheinlich das eines echten Menschen. Sind sie ungleich, handelt es sich vermutlich um einen Deepfake.

Wieso untersuchen Astronomen Künstliche Intelligenz?

Die Studie ist das Ergebnis der Forschungsarbeit von Adejumoke Owolabi, Master-Studentin an der University of Hull im englischen Yorkshire. Sie hat KI-generierte Fälschungen auf dieselbe Weise analysiert, wie Astronom:innen Bilder von Galaxien untersuchen.

„Um die Form von Galaxien zu messen, analysieren wir, ob sie zentral kompakt sind, ob sie symmetrisch sind und wie glatt sie sind. Wir analysieren die Lichtverteilung“, erklärt Kevin Pimbblet, Professor für Astrophysik und Direktor des Exzellenzzentrums für Datenwissenschaft, Künstliche Intelligenz und Modellierung. „Wir erkennen die Reflexionen auf automatische Weise und lassen ihre morphologischen Merkmale durch die CAS- und Gini-Indizes laufen“.

Normalerweise nutzen die Forschenden den Gini-Koeffizent, um zu messen, wie das Licht in einem Bild einer Galaxie auf seine Pixel verteilt ist. Dazu werden sie in aufsteigender Reihenfolge nach ihrem Lichtstrom geordnet und dann mit dem Ergebnis verglichen, das man bei einer vollkommen gleichmäßigen Lichtstromverteilung erwarten würde. Auf die gleiche Weise lassen sich auch die linken und rechten Augäpfel von Menschen vergleichen.

Die wissenschaftliche Methode, die das Team der University of Hull nutzt, sei kein Allheilmittel zur Erkennung gefälschter Bilder, so Kevin Pimbblet. Es gäbe auch falsch-positive und falsch-negative Ergebnisse. Allerdings liefere die Herangehensweise „einen Angriffsplan für das Wettrüsten bei der Erkennung von Fälschungen“.

Auch interessant: