In den letzten Wochen flammten kontroverse Diskussionen rund um Apple auf. Grund war die geplante Identifizierung von kinderpornografischen Inhalten auf den Endgeräten der Nutzer. Dieses als CSAM benanntes System wurde hauptsächlich deswegen so stark kritisiert, da Apple im Vergleich zur Konkurrenz nicht in der iCloud scannt, sondern jegliche Bilder in der lokalen Bibliothek unter die Lupe nimmt (sofern iCloud Fotos aktiv ist).

Das Problem war dabei nicht die eigentlich gute Intention von Apple, Kinder zu schützen und problematisches Material aus dem Verkehr zu ziehen, sondern das große Missbrauchspotenzial der neuen Scan-Funktion. So könnte Apple etwa x-beliebige Bilder identifizieren und an Behörden melden. So weit soll es laut dem Konzern nie kommen, trotzdem ist Skepsis angebracht.

Jetzt scheint das kalifornische Unternehmen doch etwas einzulenken. Wie Apple mitteilte, wird man sich vor der Einführung der Funktion noch etwas Zeit nehmen und auf die Kritik der Öffentlichkeit eingehen. Damit kommt das System nicht wie geplant mit iOS 15, iPadOS 15 und macOS Monterey, sondern wird voraussichtlich mit einem späteren Update nachgeliefert.

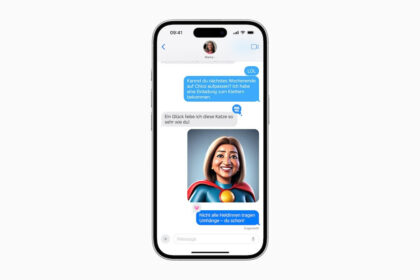

Apple spezifizierte nicht weiter, welche Änderungen man nun genau implementieren möchte und welches Feedback für das Zurückziehen der Funktion ausschlaggebend war. Daher wird es auch spannend, inwieweit der Konzern die Öffentlichkeit von seinen Mechanismen überzeugen möchte. Denn auch die Sicherheitsfeatures für iMessage werden verschoben.

Mit diesen sollte eine sichere Kommunikation für den verschlüsselten Dienst ermöglicht werden, nicht jugendfreie Inhalte werden mit der Funktion herausgefiltert und unter anderem Eltern informiert. Es bleibt abzuwarten, wie die nun geplanten Änderungen am Ende aussehen oder ob Apple vielleicht doch komplett zurückrudern wird.

Eigene Meinung:

Dass es sich Apple bei der CSAM-Implementierung anders überlegen wird, war eigentlich abzuwarten. Zu viel Kritik prasselte in den letzten Wochen auf das Unternehmen ein, gleichzeitig riskierte der Hersteller seinen guten Ruf beim Thema Datenschutz. Ich denke, dass Apple letztlich komplett zurückrudern wird und die CSAM-Funktionen nur auf iCloud ausrollt.

Via 9To5 Mac