Facebook kann eine wunderbare Möglichkeit sein, Menschen und Meinungen eine Stimme zu geben. Leider aber sind darunter auch viele Äußerungen, die klar diskriminierend und rechtswidrig sind. Aktuell kommt es insbesondere in der Flüchtlingsdebatte häufiger zu Äußerungen, die eigentlich (nicht nur) auf Facebook nichts zu suchen haben. Wer diese Inhalte aber meldet, wird teils noch selbst verwarnt. Wir haben nachgefragt: Wie viel Hass ist erlaubt, Facebook? // von Tobias Gillen

„Darum mein Appell: Saubere Straßen für Deutschland. Brummifahrer, haltet drauf“, das schreibt ein Facebook-Nutzer im Bezug auf Flüchtlinge in einem Kommentar. Sie kämen wie die Fliegen, die Polizei werde nicht mehr fertig. Die Lösung des Mannes: Einfach überfahren, dann wird das schon wieder – zumindest in der klitzekleinen Welt des Verfassers.

Dass es hierbei darum geht, Menschen zu helfen, die vor schlimmsten Situationen fliehen, vor Gewalt, Krieg, Armut – und ihnen eine faire Chance zu geben, wird leider häufig vergessen. Dass es den Menschen so schlecht geht, dass sie ihre Heimat verlassen und in eine mehr als ungewisse Zukunft aufbrechen, ebenfalls. Und dann kommen sie nach Deutschland und werden als erstes mit solchen Äußerungen konfrontiert? Das kann nicht wahr sein.

Die Gemeinschaftsstandards

Zum Glück gibt es aber noch viele Menschen, deren Welt aus mehr als nur den eigenen vier Wänden besteht. Die noch unterscheiden können zwischen Recht und Unrecht und denen es nicht zu anstrengend ist, mal anderhalb Sekunden differenziert nachzudenken, bevor sie irgendwelchen kranken Unsinn in die Welt setzen. Und zum Glück gibt es bei Facebook sowie in fast allen anderen Netzwerken „Melden“-Buttons, um derlei Kommentare als Verstöße zu markieren.

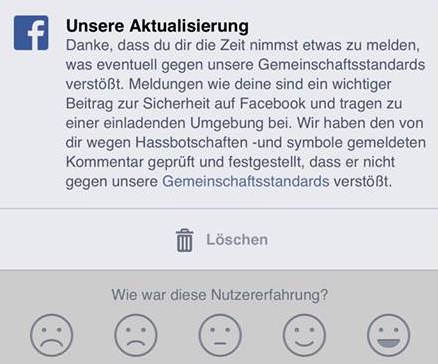

Problematisch wird es aber, wenn diese Äußerungen dann doch „nicht gegen die Gemeinschaftsstandards von Facebook“ verstoßen, wie zum Beispiel bei dem „Appell“ weiter oben und vielen weiteren Posts, die sogar noch weiter gehen. Da sind zum Beispiel Bilder vom Eingangstor zum Konzentrationslager Auschwitz, wo aus der Aufschrift „Arbeit macht frei“ mittels Photoshop „Asylantenheim“ gemacht wurde, Forderungen zur „Vergasung“ von Flüchtlingen sind ebenfalls häufig zu lesen.

„Sicherheit der Menschen hat höchste Priorität“

Wer diese Posts in Vielzahl meldet, kann am Ende sogar selbst mit Konsequenzen rechnen. Facebook verwarnt nämlich solche Nutzer irgendwann, wenn zu viele gemeldete Posts „nicht gegen die Gemeinschaftsstandards von Facebook“ verstoßen. Damit wolle man verhindern, dass das ungerechtfertigte Melde-Aufkommen im Rahmen bleibt. Etwa gab es Fälle von Medienunternehmen, die von PEGIDA-Anhängern in Reihe gemeldet wurden, nur weil denen die Berichterstattung der „Lügenpresse“ nicht passte.

Facebook lässt sich auf BASIC thinking-Nachfrage zu den Vorwürfen so zitieren: „Für Facebook ist die Sicherheit der Menschen auf Facebook von höchster Priorität.“ Und weiter: „Grundsätzlich ist es so, dass alle Inhalte, die gegen die Gemeinschaftsstandards von Facebook verstoßen, umgehend gelöscht werden.“ Guckt man sich in den Gemeinschaftsstandards so um, ist es unverständlich, warum das bei solchen Äußerungen trotzdem immer wieder nicht passiert.

Darin steht, unter dem Punkt „Hassbotschaften“:

Facebook entfernt sämtliche Hassbotschaften, d. h. Inhalte, die Personen aufgrund der folgenden Eigenschaften direkt angreifen: Rasse, Ethnizität, Nationale Herkunft, Religiöse Zugehörigkeit, Sexuelle Orientierung, Geschlecht bzw. geschlechtliche Identität oder schwere Behinderungen oder Krankheiten.

Das „Community Operations Team“ entscheidet

Um zu verstehen, wie es trotzdem sein kann, dass solche Äußerungen nicht gelöscht werden, muss man den Prozess im Hintergrund erst einmal verstehen. Wer einen Artikel meldet, muss dafür einen Grund angeben. Hier empfiehlt es sich schon, den richtigen Grund auszuwählen. Wer bei den Botschaften oben etwa „Spam“ auswählt, wird schlechte Karten haben, dass sie gelöscht werden.

Um zu verstehen, wie es trotzdem sein kann, dass solche Äußerungen nicht gelöscht werden, muss man den Prozess im Hintergrund erst einmal verstehen. Wer einen Artikel meldet, muss dafür einen Grund angeben. Hier empfiehlt es sich schon, den richtigen Grund auszuwählen. Wer bei den Botschaften oben etwa „Spam“ auswählt, wird schlechte Karten haben, dass sie gelöscht werden.

Einmal gemeldet, wandert der Post zu einem Team, das Facebook das „Community Operations Team“ nennt. Dort sitzen Muttersprachler, die jede Meldung prüfen und dann entsprechend entscheiden, ob der Post gegen die Standards verstößt. Hier trifft eine Person die Entscheidungen über die Äußerung.

Fehler in der Häufigkeit nicht erklärbar

Aus Facebook-Kreisen heißt es, dass hier Fehler nicht ausgeschlossen seien, man sich aber die Vielzahl der in der BASIC thinking-Anfrage aufgezählten Beispiele nicht erklären könne. Zumindest über eine Löschung des eigenen Profils wegen zu häufigem Melden von Inhalten brauche man sich keine Sorgen machen. Nach einer kurzen Informationen darüber sollte es kein Problem sein, den Account wieder freizuschalten.

Das löst aber noch lange nicht das Problem der Hass-Kommentare gegen Flüchtlinge oder Homosexuelle. Eine Alternative zu Facebook wäre eine (Online-)Anzeige bei der Polizei. Denn viele der meldungswürdigen Kommentare verstoßen nicht nur ganz klar gegen die Gemeinschaftsstandards von Facebook und den menschlichen Verstand, sondern auch gegen geltendes Recht. Hier ist leider genauso unklar, wie vielversprechend das ist.

Klar ist aber, dass Facebook hier ganz klar seine Pflichten vernachlässigt und dringend nachbessern sollte, zur Not eben nicht nur im „Community Operations Team“ sondern auch bei den so viel erwähnten Gemeinschaftsstandards. So wie es aktuell ist, kann und darf es nicht bleiben.