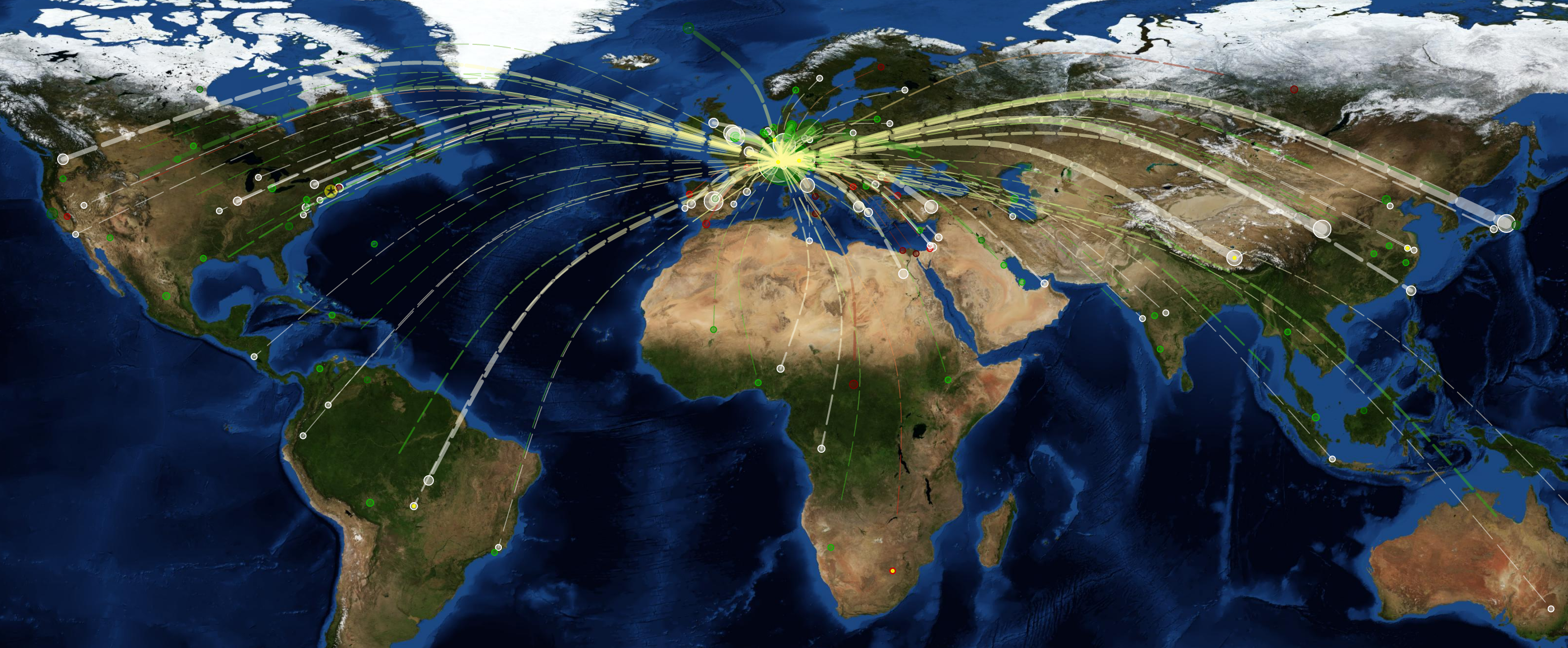

Social Media bietet neben all den vielen tollen Vorteilen natürlich auch Risiken. So ermöglicht die weltweite Vernetzung etwa eine unkontrollierte und sekundenschnelle Verbreitung von Falschmeldungen und Gerüchten. Eine erfundene Nachricht kann sich so in kürzester Zeit auf den Aktienkurs eines Unternehmens auswirken und ganz realen Schaden anrichten. Doch wie soll man wahre und falsche Berichte unterscheiden? Eine internationale Kooperation will derartigen Phänomenen nun entgegenwirken.

Memes besser und schneller begegnen

Das EU-Forschungsprojekt der privaten MODUL Universität in Wien, bei dem neben Österreich auch Deutschland, England, Schweiz, Bulgarien, Spanien und Kenia involviert sind, hat es sich zur Aufgabe gemacht, die Vertrauenswürdigkeit von Social-Media-Inhalten besser beurteilen zu können – unter minimalem Ressourcen-Einsatz.

Da das „systematische“ Analysieren der Inhalte bislang nicht möglich sei, arbeite man mit „linguistischen und graphischen Methoden“ sowie mit Technologien zur Big-Data-Analye. Die Ergebnisse sollen dann Anwendung bei medizinischen Informationssystemen sowie im Journalismus finden. Bei Ersterem wäre etwa die Verifizierung von Gerüchten einer weltweiten Pandemie denkbar. Könnten Experten diesen „Memes“ besser und schneller begegnen, könnte man Panik und Unwahrheiten früher bekämpfen. Bei Letzterem seien die britische BBC und der Südwestrundfunk (SWR) als Partner involviert.

Vertrauenswürdigkeit

Dazu arbeitet das Team etwa mit webLyzard – ein auf Big Data spezialisiertes Unternehmen – zusammen. Aber auch das ändert nichts an der Mammutaufgabe, die sich das internationale Team da gesetzt hat. Im neuen Projekt – passenderweise „Pheme“ genannt – geht es um die Erfassung von Vertrauenswürdigkeit. Man gehe dazu vier Arten von Gerüchten nach:

- Der Spekulation

- Der Kontroverse

- Der Missinformation

- Der Desinformation

Noch nicht wirklich konkret

Das Problem bei der Einordnung in eine der vier Kategorien läge bislang noch darin, dass man dafür das Gerücht – also Tweet oder Post – in den sozialen Kontext des Nutzers setzen müsste. Diesen aber automatisiert zu erfassen und zu interpretieren sei bislang noch nicht gelungen. Nun wolle man aber genau dort ansetzen und Sprachtechnologie, Web Science und Analyse sozialer Netzwerke mit Visualisierungstechniken kombinieren und aus den vielen verschiedenen Informationen, die aus einer Botschaft gelesen werden können, möglichst genau deren sozialen Kontext und damit die Einordnung ermöglichen. Im Fach-Chinesisch nennt man das dann „interdisziplinäre Netzwerkforschung“.

Der Ansatz der zumindest halbwegs automatischen Verifizierung von Social-Media-Inhalten ist genau richtig. Viel zu häufig machen Unwahrheiten und vorschnelle Gerüchte die Runde um die Welt – ohne auch nur einmal geprüft worden zu sein. Insgesamt aber scheinen die Ideen des „Pheme“-Teams zwar konzeptionell – also auf dem Papier – einigermaßen vorhanden. So wirklich konkrete Ergebnisse wollte man aber bislang noch nicht vorzeigen. Es ist also noch viel Luft nach oben möglich, wenngleich klar sein sollte: Die Aufgabe, die sich das Team gesteckt hat, ist eine enorm große.

Bild: MODUL Universität Wien