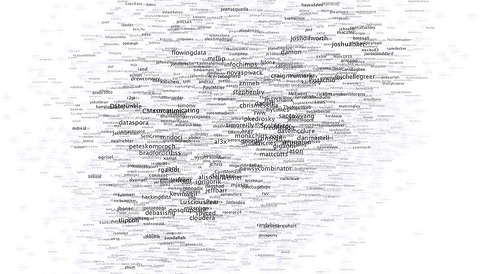

Zahlreiche Wissenschaftler beschäftigen sich mit der Frage, was die Social-Media-Welt im Innersten zusammenhält. Mit neuen Ergebnissen einer groß angelegten Twitter-Untersuchung ist man dieser Frage nun ein Stück näher gekommen, denn Wissenschaftler an der „University of California Santa Barbara“ haben das „Social Media Genome“ gefunden. Ihre These: Themenspezifisches Nutzerverhalten hinterlässt einen individuellen Fingerabdruck. Dieser kann analysiert und zur Vorhersage künftigen Verhaltens genutzt werden. Über 450 Millionen Tweets haben sie sich angeschaut.

Prädiktive Analyse im Trend

Nicht erst seit dem NSA-Skandal wissen wir, dass das wir im Netz Spuren hinterlassen, mit denen ein Profil über uns erstellt werden kann. Das betrifft alles, was ich täglich im Netz suche, wie ich mich dort öffentlich äußere oder wer in meinen Netzwerken ist. Die Vermutung der Wissenschaftler, dass mein bisheriges Verhalten mein künftiges Verhalten vorhersagbar macht, ist insofern erst einmal naheliegend.

Schwierig wird es jedoch, wenn es an die Beweisführung geht. Denn, anders als ein Agent mit Hirn und Verstand, kann eine Maschine eben nur sehr eingeschränkt solche Vorhersagen treffen.

Unter dem Stichwort „predictive analysis“ blühen seit einigen Jahren wissenschaftliche Ansätze, die sich an der neuen Big-Data-Welt abarbeiten. Grundsätzlich geht es dabei immer auch um die Frage, wie aus einer großen Datenmenge, vom Computer unterstützt, sinnvolle Informationen extrahiert werden können. Mit diesem Wissen sollen schließlich stabile Vorhersagen getroffen werden.

Der Nutzer ist komplex

Stabile Zusammenhänge zu finden ist dabei jedoch nicht so leicht. Die Wissenschaftler aus Kalifornien bemängeln, dass bisherige Studien über die Verbreitung von Informationen im Netz lediglich zwei verschiedene Schwerpunkte gesetzt haben: einerseits stand die Netzwerkstruktur (z.B. der Freundeskreis) im Vordergrund, andererseits das Sentiment (die Bewertung eines Themas).

Behavioristische Modelle, die stabiles thematisches Nutzerverhalten in den Mittelpunkt stellen, sind demgegenüber untergewichtet. Zur Vorhersage über die Verbreitung von Informationen im Netz ist dieses spezifische Verhalten jedoch wichtig. Mit dem „genotype model“ sollen es analytisch erfassbar gemacht werden.

Our main premise is that, based on observed network behavior, we can derive a unique signature of a user.

Die Kunst der Tweet-Kategorisierung

Zwei Datensets standen den Wissenschaftlern zur Verfügung: Das große besteht aus 42 Millionen Nutzern und 467 Millionen Tweets in einem Zeitraum von sechs Monaten. Das andere berücksichtigt Daten aus dem Jahr 2012, die über die öffentliche Twitter-API gewonnenen wurden; mit 9.000 Nutzern und 14,5 Millionen Tweets.

Analysiert wurden sie anhand der Hashtags, die jeweils einer von fünf möglichen Kategorien zugeordnet werden konnten: Sport, Politik, Celebrities, Business und Wissenschaft und Technologie. Ein Set von Initial-Hashtags wurde so von vorne herein entsprechenden Kategorien zugeordnet. In einem mehrstufigen Klassifizierungsverfahren wurde das Set dann stückchenweise erweitert.

Bezogen auf die einzelnen Nutzer kann durch dieses Vorgehen analysiert werden, worüber geschrieben wird und wann es besonders wahrscheinlich ist, dass etwas geschrieben und geteilt wird. Noch konsistenter wird das Bild, wenn man die Nutzer zu Gruppen bzw. Netzwerken bündelt. Die Fehleranfälligkeit wird dadurch zusätzlich verringert.

Schritt für Schritt zur Weltformel

Für die Verfasser der Studie sind die Ergebnisse eindeutig: Zur Vorhersage von Nutzerverhalten im Netz müssen bisherige Modelle über Struktur und Inhalt der Netzkommunikation ergänzt werden; und zwar um das individuelle- und Netzwerk-Verhalten. Damit können Fehler in der Prognose vermieden werden.

Das klingt soweit plausibel. Praktischen Nutzen haben die Ergebnisse durchaus. Denn bekanntermaßen sind Firmen in hohem Maße daran interessiert, das künftige Verhalten ihrer Nutzer einschätzen zu können. Klar, das können sie derzeit schon ganz gut. Entgegen der weit verbreiteten Annahme, dass „die bösen Firmen“ eh schon alles wissen muss man aber gegenwärtig auch eingestehen, dass die inhaltliche Analyse großer Datenmengen noch recht unerforscht ist. Mit anderen Worten: von der Weltformel ist man hier noch sehr weit entfernt. Zumindest hoffe ich, dass sich die Welt in mehr als fünf Themencluster einteilen lässt.

Das Grundproblem bei einer solchen Analyse ist und bleibt ja: bei Millionen von Nachrichten, Tweets, Facebook-Einträgen und einer ganzen Reihe neuer Themen, die täglich aufkommen, ist eine automatische Analyse derzeit alles andere als einfach. Gleichzeitig man auf die Maschinen-Analyse angewiesen, weil kein Mensch diese Daten sonst bewältigen könnte.