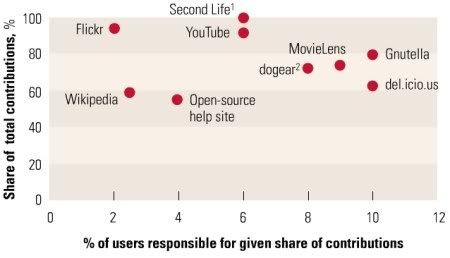

die berühmte 1% Regel, bestimmt schon mal gehört. Gerade auf user generated Plattformen wie zB der Wikipedia. Das Phänomen besagt, dass nur ein Bruchteil der User einen immens hohen Anteil der Inhalte stemmt. Und damit erst überhaupt die Plattform für die zahlreichen anderen User spannend macht. McKinsey hat dazu eine Chart erstellt. Im Rahmen einer Untersuchung zu Intranets und dem Einsatz von Wikis und Blogs: How companies can make the most of user-generated content (nur mit Anmeldung).

Auf der Y-Achse: wieviel Prozent des Contents habe die Wenigen produziert

Auf der X-Achse: wieviel sind diese Wenige in Prozent

Beispiel: in Second Life werden angeblich 100% der „Inhalte“ von lediglich 6% der Nutzer erstellt. Im Vergleich dazu sind auf del.icio.us weitaus mehr User produktiv, denn dort tragen gar 10% aller User rund 60% zum Content bei und vica versa 90% der User 40% des Contents.

Auch spannend: mit der Zeit werden immer mehr User aktiv. Dieses Phänomen lässt sich auf Wikipedia beobachten. Interestingly, some research suggests that, over time, participation rates throughout the user group increase. In 2004, for example, 90 percent of the contributions to Wikipedia came from just 2 percent of its users; by 2006, the top 2.5 percent of them were responsible for only 60 percent of all new content…

Ein Gedanke: ich bin mir sehr sicher, dass zB Photobucket als der Fotodienst No.1 in den USA weitaus mehr produzierende User aufweist. Was auch kein Wunder ist, denn er ist viel weniger auf Sharing der Bilder untereinander als auf das Hosting der Bilder für den User selbst ausgerichtet. Da letztlich der Need eigene Bilder online abzulegen weitaus größer ist, als mit fremden Menschen über die eigenen Bilder zu reden. Denk ich mal. Aber, man muss sich fragen, ob partizipative Plattformen nicht viel mehr User aktivieren könnten, indem sie auch den „ego-usern“ einen Platz im Sinne von Ego-Funktionen anbieten. Statt immer nur den Sharing-Gedanken verkaufen. Welchen Vorteil hätte so etwas? Mehr Content, mehr Andockflächen für mehr User, so mein Gedanke. Gedanklich wäre es doch vorstellbar, dass es Flickr-We und ein Flickr-You gibt und man die Bilder aus dem You-Bereich auch im We-Bereich anzeigt, insofern der Ego-User das zulässt bzw. will.

Egal wie man es dreht und wendet, es gilt das eherne Gesetz, dass die wenigen Aktiven überdurchschnittlich wichtig sind für eine partizipative Plattform und man ein starkes Augenmerk auf diese Usergruppe zwingend richten muss. Ebenso heißt es umgekehrt, dass man bei Weitem nicht alle User aktivieren muss und den Passiven den Zugang zum Inhalt auch suchmaschinenseitig auf die Plattform so einfach wie nur möglich gestaltet. Dazu gehört es auch, dass man die „Surfability“ perfekt gestaltet und die Absprungrate soweit es geht nach unten drückt. Normalerweise spricht man dabei von „Stickyness“. Doch Stickyness und Surfability würde ich gedanklich trennen. Denn, wenn der Inhalt unspannend ist, nützt die beste Surfability nix. Umgekehrt, ist die Surfability mies, nützt der beste Inhalt nix, er vermodert und der User hat keinen Bock, sich auf der Plattform durchzuquälen. Technisch ist das eigentlich einfach, im Wesentlichen gehört zur Surfability natürlich die Geschwindigkeit des Seitenaufbaus. Umzusetzen fällt das nicht easy, da man uU nicht die Ressourcen hat, zig Server aufzustellen. Oder aber, man hat so schlecht programmiert, dass man viel zuwenig User pro Server verkraftet. Auf Dauer kann das in doppelter Hinsicht tödlich werden: es kann sein, dass man zwar ständig neue User gewinnt, doch viele springen wieder ab nach einer gewissen Zeit (wegen lahmer Responszeit eben) und andererseits klebt man sich einen Server nach dem anderen an die Backe und kommt kostenseitig in die Todeszone (no money, no hope).